NVIDIA H200 搭載 NVIDIA DGX H200

NVIDIA H200 GPU搭載 DGXシステム「NVIDIA DGX H200」

NVIDIA DGX H200は、AIとデータサイエンスのワークロードに対応するために設計されたAIスーパーコンピュータです。このシステムはNVIDIA Hopperアーキテクチャに基づく最先端のGPUを搭載し、前例のないパフォーマンスとスケーラビリティを提供します。

(※NVIDIA H200の詳しい説明はこちらをご覧ください。)

さらに、NVIDIA ConnectX®-7 スマートネットワークインターフェイスカード(SmartNIC)とNVIDIA BlueField®-3 データプロセシングユニット(DPU)により400 Gb/s InfiniBand接続での超高速データ転送が可能です。高帯域幅と低レイテンシーを実現することで、分散トレーニングや大規模データ解析のパフォーマンスを最大化します。

この次世代アーキテクチャは最先端のGPU技術、スケーラブルな設計、高速ネットワーキングにより、自然言語処理やディープ ラーニングによるレコメンデーションモデルなど、最も要求の厳しいAIとデータサイエンスのワークロードに対応します。

多様な条件に適合するリーダーシップクラスのインフラ

企業や研究機関でAI を利用する際に重要なのは、パフォーマンスと機能だけではありません。組織のIT 要件と運用要件に適合することも重要です。NVIDIA DGX H200 は、オンプレミスに導入して直接管理できるほか、NVIDIA DGX 対応のデータセンターへのコロケーション、NVIDIA DGX Foundry でのレンタル、NVIDIA 認定のマネージド サービス プロバイダーを介した利用が可能です。また、NVIDIA DGX-Ready ライフサイクル管理プログラムにより、最新のシステムの導入を維持するための予測性の高い財務モデルを利用できます。これを利用すると、忙しいIT スタッフの負担を増やすことなく、従来のIT インフラと同じように簡単にNVIDIA DGX H200 を活用、入手できるため、明日を待たずにすぐAI をビジネスに活用できます。

NVIDIA DGX SuperPOD、BasePOD へのスケールアウト

NVIDIA DGX H200 は、SuperPODおよびBasePODの基盤として、さまざまな規模のAIプロジェクトに対して最適なソリューションを提供します。NVIDIA DGX SuperPODは、最も困難なAIおよびハイパフォーマンスコンピューティング(HPC)ワークロードのための俊敏でスケーラブルなパフォーマンスと、リーダーシップクラスのインフラストラクチャを統合します。

NVIDIA DGX BasePODは、従来のAIインフラストラクチャの拡張に伴う設計上の課題、長い導入サイクル、管理の複雑さを解消し、企業向けの規定型AIインフラストラクチャを提供します。

NVIDIA DGX H200 構成

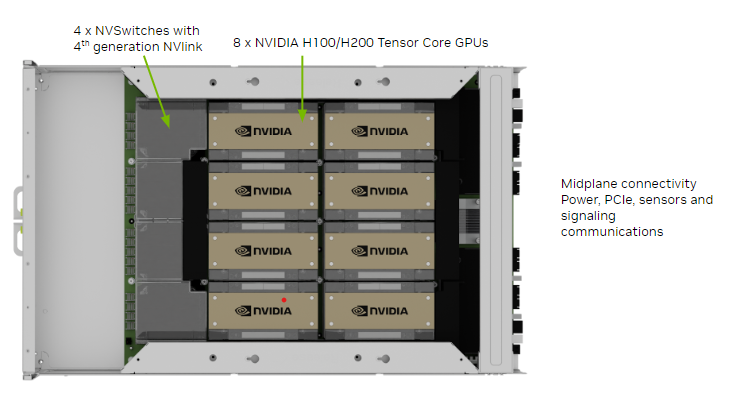

◆ NVIDIA H200 GPU x8、合計 GPU メモリ 1128GB1GPU あたり12NVIDIA® NVLinks®、GPU間の双方向帯域幅900GB/秒

◆ NVIDIA NVSWITCHES™ x4

7.2 テラバイト/秒のGPU間双方向帯域幅、Ampere世代比1.5倍以上

◆ NVIDIA CONNECTX®-7 x8 および、NVIDIA BLUEFIELD® DPU 400Gb/秒 ネットワークインターフェイス x2

ピーク時の双方向ネットワーク帯域幅 1TB/秒

◆ デュアル x86 CPU と 2TB システム メモリ

AI への依存が非常に高い仕事を可能にするパワフルな CPU

◆ 30TB NVME SSD

最高のパフォーマンスを実現するための高速ストレージ

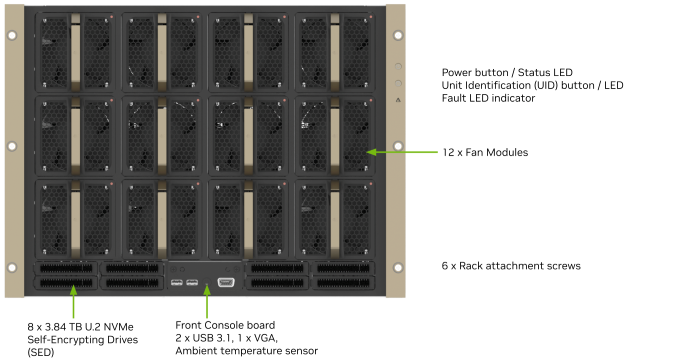

Front Panel Connections and Controls

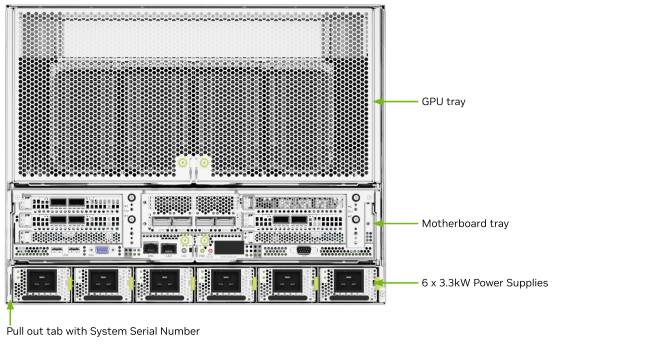

Rear Panel Modules

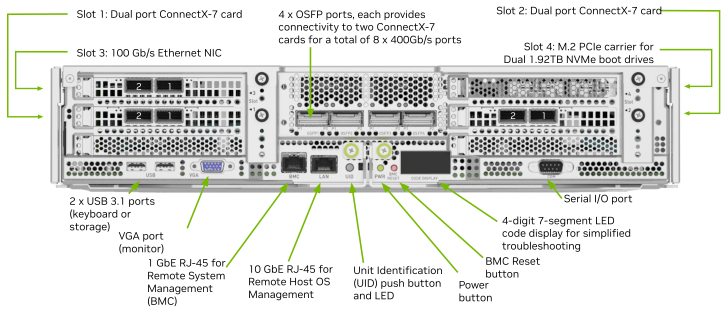

Motherboard Connections and Controls

GPU Tray Components

NVIDIA DGX H200 仕様

| GPU | NVIDIA H200 Tensor Core GPU 141 GB x 8基 |

| GPUメモリ | Total 1128 GB |

| パフォーマンス | 32 petaFLOPS FP8 |

| NVIDIA NV Switch数 | 4 |

| CPU | Dual x86 |

| システムメモリ | 2TB |

| ネットワーク | 4 個の OSFP ポートで 8 基の シングルポート ConnectX-7 へ接続 400Gb/s InfiniBand/Ethernet 2 基のデュアルポート NVIDIA BlueField-3 DPU VPI 400Gb/s InfiniBand/Ethernet x1 200Gb/s InfiniBand/Ethernet x1 10Gb/s オンボード NIC(RJ45 付き) 100Gb/s Ethernet オプション NIC ホスト ベースボード管理コントロー ラー(BMC)(RJ45 付き) 2x NVIDIA BlueField-3 DPU BMC (それぞれ RJ45 コネクタで接続) |

| ストレージ | OS: 1.92 TB M.2 NVMe E drives × 2 内部ストレージ: Cache: 30 TB (3.84 TB × 8) U.2 NVMe drives |

| PSU | 6 x 3.3Kw Redundant |

| システム電力 | 10.2kw(TBD) |

| サイズ | 353 x 447 x 844(mm) RackUnits 8U |

| ソフトウェア | DGX OS / Ubuntu:オペレーティング システム NVIDIA AI Enterprise:最適化された AI ソフトウェア NVIDIA Base Command™:オーケストレーション、スケジューリング、クラスター管理 |

| 動作温度範囲 | 5℃~30℃ |

※仕様は予告なしに変更されることがあります。

※データシートはこちらから入手可能です。

導入のご相談はDGX国内累計販売実績No.1の株式会社ジーデップ・アドバンスまで

ジーデップ・アドバンスはDGXに対する豊富な実績から、NVIDIAのベストパートナーとして受賞されております。

また、DGXのソフトウェアスタックに標準採用されるBase Command オーケストレーションツールについても、そのポートフォリオのベースとなっている Bright Cluster Manager の代理店として国内トップクラスの知見を有しています。DGX H100という最新で最強のツールをスムーズに導入して頂くために是非私達にお手伝いをさせて下さい。